Reducción de la dimensionalidad con t-SNE

Voy a explicar aquí lo que he aprendido recientemente sobre t-SNE, una técnica para reducir la dimensionalidad de conjuntos de datos. Es una alternativa moderna a MDS o PCA.

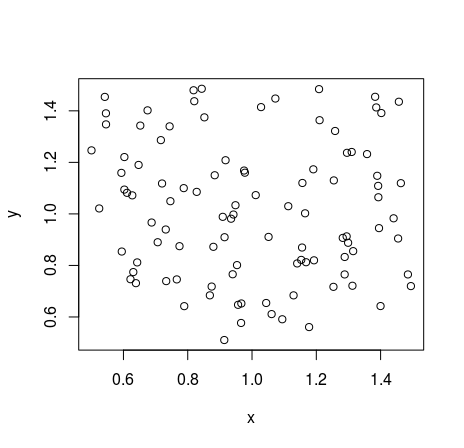

Partimos de puntos $x_1, \dots, x_n$ y buscamos otros $y_1, \dots, y_n$ en un espacio de menor dimensión. Para ello construiremos primero $n$ distribuciones de probabilidad, $p_i$ sobre los enteros $1, \dots, n$ de forma que

$$ p_i(j) \propto d_x(x_i, x_j),$$

donde $d_x$ es una determinada distancia entre puntos en el espacio original. De la misma manera, construimos sendas distribuciones de probabilidad, $q_i$,